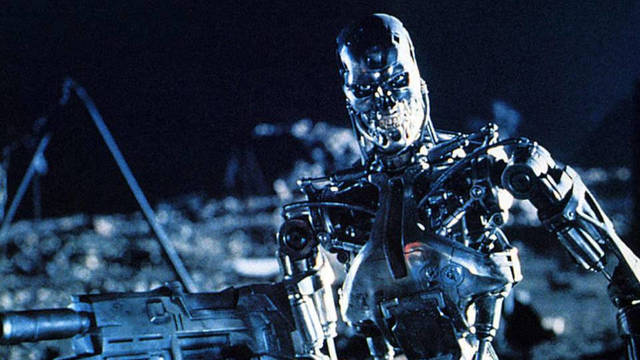

"Las armas totalmente autónomas decidirían quién vive y quién muere, sin más intervención humana", dice la ONG Human Rigth Watch que pide prohibirlas

Los 'robots asesinos': Los peligros de usar la inteligencia artificial para matar con armas automáticas

El peligro lo han detectado y confirman 129 organizaciones no gubernamentales y empresas que han iniciado una cruzada internacional para prohibir los robots asesinos impulsados por inteligencia artificial. El 21 de octubre, las organizaciones impulsoras y 60 países apoyaron una carta ante la Organización de Naciones Unidas (ONU) para solicitar que se establezca una negociación y posterior tratado internacional contra las armas controladas por inteligencia artificial.

Robot asesino que quería utilizar Rusia para pilotar sus naves espaciales.

El problema de la inteligencia artificial es que operaría sin intervención humana, por tanto, sin capacidades naturales de comprensión. Desde Human Right Watch (HRW) alertan de que: "Las armas totalmente autónomas decidirían quién vive y muere, sin más intervención humana, lo que cruza un umbral moral".

El peligro de la ausencia de normativa internacional

Según las ONG que promovieron el comunicado, ante la ausencia de normativa internacional y la falta de acuerdo entre países está facilitando que algunos gobiernos y empresas avancen en el desarrollo de máquinas asesinas automáticas. HRW pone en duda que las máquinas puedan hacer valer el derecho internacional humanitario. Elementos como la proporcionalidad y necesidad no son asumidas por los robots autómatas.

.@DavidWreckham enters the #FirstCommittee with a simple message: Support the call to ban #killerrobots @BanKillerRobots pic.twitter.com/R7UhuConIc

— Allison Pytlak (@a_pytlak) October 21, 2019

Entre los firmantes hay cuatro empresas españolas. Ángel Lis, fundador de la empresa de inteligencia artificial Neuronalbite ha explicado a elcierredigital.com que la inteligencia artificial se basa en logaritmos para descifrar e identificar patrones. “Es algo que hacen muy bien. Mientras en una gráfica las personas podemos analizar uno, dos o tres datos al mismo tiempo, con inteligencia artificial podemos analizar millones de datos en un mismo lugar” comenta Lis.

“El problema es que cuando emites logaritmos de identificación para actividad armada, se pierde el discernimiento humano de lo que es correcto. Si le dices a una máquina que mate, va a matar sin que nadie decida si está bien o no”, explica el experto.

Algunas empresas tendrían prototipos de robots asesinos muy avanzados.

Un ejemplo que ofrece el fundador de la empresa, es que si un dron es programado para atacar un determinado tipo de estructuras, el robot lo hará detectando las características preinstaladas. No obstante, la máquina no podrá discernir si debe o no atacar si localiza un colegio que cumpla esas características. “No hay raciocinio”, explica Lis.

Hay países que ya lo están desarrollando

Otro ejemplo que ofrece es el sistema de reconocimiento facial, probado en Estados Unidos por la Policía. Según el experto consultado, los sistemas de reconocimiento tienden a relacionar a personas negras con personas buscadas.

“Las máquinas reconocen patrones por raza”, asegura Lis, quien explica que las similitudes entre personas pueden ser el fallo más importante de la inteligencia artificial, algo que se agravaría “porque estamos hablando de asesinar personas”.

Dron asesino automático.

Hasta ahora, no hay avances muy importantes en el tema armamentístico, pero Lis asegura que: "con seguridad hay países que lo investigan y desarrollan. La carta la emitimos como una previsión para avisar sobre el riesgo. Algo mal utilizado puede ser tremendamente peligroso”.

El técnico considera que la principal diferencia entre un arma operada por una máquina y una utilizada por una persona es que “cuando una persona aprieta el gatillo, tiene convicciones, la máquina solo debe apretar el gatillo”.

Por ahora, la ONU no ha emitido respuesta ante la carta enviada por dichas organizaciones. También se ha dirigido esta campaña a empresas como Microsoft y Amazon. Google se ha desmarcado de investigaciones de este tipo y sigue corrigiendo su propia inteligencia artificial, que generó polémica en 2016 tras confundir a negros con “gorilas”. Elon Musk, fundador de Tesla, ha firmado la carta y ha hecho llamamientos públicos para limitar este tipo de desarrollo que entrañan tantos riesgos.